10 công cụ quét web để trích xuất dữ liệu trực tuyến / Internet

Mục Chính

10 công cụ quét web để trích xuất dữ liệu trực tuyến

Công cụ quét web được phát triển đặc biệt để trích xuất thông tin từ các trang web. Chúng còn được gọi là công cụ thu hoạch web hoặc công cụ trích xuất dữ liệu web. Những công cụ này hữu ích cho bất cứ ai cố gắng thu thập một số dạng dữ liệu từ trên mạng. Quét web là kỹ thuật nhập dữ liệu mới không yêu cầu gõ lặp đi lặp lại hoặc dán sao chép.

Những phần mềm này tìm kiếm dữ liệu mới bằng tay hoặc tự động, tìm nạp dữ liệu mới hoặc cập nhật và lưu trữ chúng để bạn dễ dàng truy cập. Ví dụ: người ta có thể thu thập thông tin về các sản phẩm và giá của chúng từ Amazon bằng cách sử dụng công cụ nạo. Trong bài đăng này, chúng tôi liệt kê các trường hợp sử dụng các công cụ quét web và 10 công cụ quét web hàng đầu để thu thập thông tin, với mã hóa bằng 0.

Các trường hợp sử dụng công cụ quét web

Các công cụ quét web có thể được sử dụng cho các mục đích không giới hạn trong các tình huống khác nhau nhưng chúng tôi sẽ sử dụng một số trường hợp sử dụng phổ biến áp dụng cho người dùng phổ thông.

Thu thập dữ liệu cho nghiên cứu thị trường

Các công cụ quét web hoàn toàn có thể giúp bạn theo kịp nơi mà công ty hoặc ngành của bạn sẽ hướng tới trong sáu tháng tới, đóng vai trò là một công cụ can đảm và mạnh mẽ cho điều tra và nghiên cứu thị trường. Các công cụ hoàn toàn có thể tìm nạp ata từ nhiều nhà cung ứng nghiên cứu và phân tích dữ liệu và công ty nghiên cứu và điều tra thị trường và hợp nhất chúng thành một vị trí để thuận tiện tìm hiểu thêm và nghiên cứu và phân tích.

Trích xuất thông tin liên hệ

Những công cụ này cũng hoàn toàn có thể được sử dụng để trích xuất dữ liệu như email và số điện thoại cảm ứng từ những website khác nhau, giúp hoàn toàn có thể có list những nhà sản xuất, nhà phân phối và những người chăm sóc khác đến doanh nghiệp hoặc công ty của bạn, bên cạnh những địa chỉ liên hệ tương ứng của họ.

Tải xuống Giải pháp từ StackOverflow

Sử dụng công cụ quét web, người ta cũng hoàn toàn có thể tải xuống những giải pháp để đọc hoặc tàng trữ ngoại tuyến bằng cách thu thập dữ liệu từ nhiều website ( gồm có StackOverflow và những website Q. và A khác ). Điều này làm giảm sự nhờ vào vào những liên kết Internet đang hoạt động giải trí vì những tài nguyên luôn sẵn có mặc dầu có sẵn truy vấn Internet.

Tìm kiếm việc làm hoặc ứng viên

Đối với những nhân viên cấp dưới đang tích cực tìm kiếm nhiều ứng viên tham gia nhóm của họ hoặc cho những người tìm việc đang tìm kiếm một vai trò đơn cử hoặc vị trí tuyển dụng, những công cụ này cũng hoạt động giải trí rất tốt để lấy dữ liệu dựa trên những bộ lọc được vận dụng khác nhau và lấy dữ liệu hiệu suất cao mà không cần bằng tay thủ công tìm kiếm.

Theo dõi giá từ nhiều thị trường

Nếu bạn thích shopping trực tuyến và thích dữ thế chủ động theo dõi giá của những loại sản phẩm bạn đang tìm kiếm trên nhiều thị trường và shop trực tuyến, thì bạn chắc như đinh cần một công cụ quét web.

10 công cụ quét web tốt nhất

Chúng ta hãy xem 10 công cụ quét web tốt nhất hiện có. Một số trong số họ là không lấy phí, 1 số ít trong số họ có thời hạn dùng thử và kế hoạch hạng sang. Hãy xem chi tiết cụ thể trước khi bạn ĐK với bất kỳ ai cho nhu yếu của bạn.

Nhập khẩu

Import.io cung cấp một trình xây dựng để tạo các bộ dữ liệu của riêng bạn bằng cách nhập dữ liệu từ một trang web cụ thể và xuất dữ liệu sang CSV. Bạn có thể dễ dàng quét hàng ngàn trang web trong vài phút mà không cần viết một dòng mã và xây dựng hơn 1000 API dựa trên yêu cầu của bạn.

Import.io sử dụng công nghệ tiên tiến để lấy hàng triệu dữ liệu mỗi ngày, điều mà các doanh nghiệp có thể tận dụng với các khoản phí nhỏ. Cùng với công cụ web, nó cũng cung cấp một ứng dụng miễn phí cho Windows, Mac OS X và Linux để xây dựng trình trích xuất dữ liệu và trình thu thập dữ liệu, tải xuống dữ liệu và đồng bộ hóa với tài khoản trực tuyến.

Webhose.io

Webhose.io cung cấp quyền truy cập trực tiếp vào dữ liệu có cấu trúc và thời gian thực từ việc thu thập hàng ngàn nguồn trực tuyến. Trình quét web hỗ trợ trích xuất dữ liệu web bằng hơn 240 ngôn ngữ và lưu dữ liệu đầu ra vào các định dạng khác nhau bao gồm XML, JSON và RSS.

Webhose. io là một ứng dụng web dựa trên trình duyệt sử dụng công nghệ tiên tiến thu thập dữ liệu độc quyền để thu thập dữ liệu khổng lồ từ nhiều kênh trong một API. Nó phân phối gói không tính tiền để triển khai 1000 nhu yếu / tháng và gói bảo hiểm USD 50 / tháng cho 5000 nhu yếu / tháng.

Dexi.io (trước đây gọi là CloudScrape)

CloudScrape hỗ trợ thu thập dữ liệu từ bất kỳ trang web nào và không yêu cầu tải xuống như Webhose. Nó cung cấp trình chỉnh sửa dựa trên trình duyệt để thiết lập trình thu thập thông tin và trích xuất dữ liệu trong thời gian thực. Bạn có thể lưu dữ liệu được thu thập trên nền tảng đám mây như Google Drive và Box.net hoặc xuất dưới dạng CSV hoặc JSON.

CloudScrape cũng hỗ trợ truy cập dữ liệu ẩn danh bằng cách cung cấp một bộ máy chủ proxy để ẩn danh tính của bạn. CloudScrape lưu trữ dữ liệu của bạn trên các máy chủ của nó trong 2 tuần trước khi lưu trữ dữ liệu đó. Công cụ quét web cung cấp miễn phí 20 giờ cạo râu và sẽ có giá 29 đô la mỗi tháng.

Scrapinghub

Scrapinghub là một công cụ trích xuất dữ liệu dựa trên đám mây giúp hàng ngàn nhà phát triển tìm nạp dữ liệu có giá trị. Scrapinghub sử dụng Crawlera, công cụ quay vòng proxy thông minh hỗ trợ bỏ qua các biện pháp đối phó bot dễ dàng thu thập dữ liệu các trang web lớn hoặc được bảo vệ bằng bot.

Xem thêm: Tìm việc Làm Giám đốc Đầu tư và Phát triển Dự án Tuyển Dụng 19/04/2023 | https://thomaygiat.com

Scrapinghub chuyển đổi toàn bộ trang web thành nội dung có tổ chức. Đội ngũ chuyên gia sẵn sàng giúp đỡ trong trường hợp trình xây dựng thu thập thông tin của nó không thể đáp ứng yêu cầu của bạn. Gói miễn phí cơ bản của nó cung cấp cho bạn quyền truy cập vào 1 lần thu thập thông tin đồng thời và gói cao cấp của nó với $ 25 mỗi tháng cung cấp quyền truy cập lên đến 4 lần thu thập dữ liệu song song.

Phân tích

ParseHub được xây dựng để thu thập dữ liệu một và nhiều trang web có hỗ trợ JavaScript, AJAX, phiên, cookie và chuyển hướng. Ứng dụng sử dụng công nghệ máy học để nhận ra những tài liệu phức tạp nhất trên web và tạo tệp đầu ra dựa trên định dạng dữ liệu cần thiết.

ParseHub, ngoài ứng dụng web, còn có sẵn dưới dạng ứng dụng máy tính để bàn miễn phí cho Windows, Mac OS X và Linux cung cấp một gói miễn phí cơ bản bao gồm 5 dự án thu thập dữ liệu. Dịch vụ này cung cấp gói cao cấp với giá 89 đô la mỗi tháng với sự hỗ trợ cho 20 dự án và 10.000 trang web mỗi lần thu thập thông tin.

Hình ảnh trực quan

VisualScraper là một phần mềm trích xuất dữ liệu web khác, có thể được sử dụng để thu thập thông tin từ web. Phần mềm giúp bạn trích xuất dữ liệu từ một số trang web và tìm nạp kết quả theo thời gian thực. Hơn nữa, bạn có thể xuất trong các định dạng khác nhau như CSV, XML, JSON và SQL.

Bạn có thể dễ dàng thu thập và quản lý dữ liệu web với nó giao diện nhấp chuột đơn giản. VisualScraper có các gói miễn phí cũng như cao cấp bắt đầu từ $ 49 mỗi tháng với quyền truy cập vào các trang 100K +. Ứng dụng miễn phí của nó, tương tự như Parsehub, có sẵn cho Windows với các gói C ++ bổ sung.

Spinn3r

Spinn3r cho phép bạn lấy toàn bộ dữ liệu từ blog, tin tức & trang web truyền thông xã hội và nguồn cấp dữ liệu RSS & ATOM. Spinn3r được phân phối với một API firehouse quản lý 95% của công việc lập chỉ mục. Nó cung cấp một bảo vệ thư rác tiên tiến, giúp loại bỏ thư rác và sử dụng ngôn ngữ không phù hợp, do đó cải thiện an toàn dữ liệu.

Spinn3r nội dung chỉ mục tương tự như Google và lưu dữ liệu được trích xuất trong các tệp JSON. Trình quét web liên tục quét web và tìm các bản cập nhật từ nhiều nguồn để giúp bạn có được các ấn phẩm thời gian thực. Bảng điều khiển quản trị của nó cho phép bạn kiểm soát thu thập thông tin và tìm kiếm toàn văn bản cho phép thực hiện các truy vấn phức tạp trên dữ liệu thô.

80legs

80legs là một công cụ thu thập dữ liệu web mạnh mẽ nhưng linh hoạt có thể được cấu hình theo nhu cầu của bạn. Nó hỗ trợ tìm nạp một lượng lớn dữ liệu cùng với tùy chọn tải xuống dữ liệu được trích xuất ngay lập tức. Máy cạp web yêu cầu thu thập hơn 600.000 tên miền và được sử dụng bởi những người chơi lớn như MailChimp và PayPal.

Nó là ‘Datafiniti’cho phép bạn tìm kiếm toàn bộ dữ liệu một cách nhanh chóng. 80legs cung cấp khả năng thu thập dữ liệu web hiệu suất cao, hoạt động nhanh chóng và tìm nạp dữ liệu cần thiết chỉ trong vài giây. Nó cung cấp gói miễn phí cho 10K URL mỗi lần thu thập thông tin và có thể được nâng cấp lên gói giới thiệu với giá $ 29 mỗi tháng cho 100K URL mỗi lần thu thập thông tin.

Cái nạo

Scraper là một tiện ích mở rộng của Chrome với các tính năng trích xuất dữ liệu hạn chế nhưng nó hữu ích cho việc nghiên cứu trực tuyến và xuất dữ liệu sang Bảng tính Google. Công cụ này dành cho người mới bắt đầu cũng như các chuyên gia có thể dễ dàng sao chép dữ liệu vào bảng tạm hoặc lưu trữ vào bảng tính bằng OAuth.

Scraper là một công cụ miễn phí, hoạt động ngay trong trình duyệt của bạn và tự động tạo các XPath nhỏ hơn để xác định URL để thu thập dữ liệu. Nó không cung cấp cho bạn sự dễ dàng của việc thu thập dữ liệu tự động hoặc bot như Nhập, Webhose và những người khác, nhưng nó cũng là một lợi ích cho người mới như bạn không cần phải giải quyết cấu hình lộn xộn.

Trung tâm OutWit

OutWit Hub là một tiện ích bổ sung của Firefox với hàng tá tính năng trích xuất dữ liệu để đơn giản hóa các tìm kiếm trên web của bạn. Công cụ này có thể tự động duyệt qua các trang và lưu trữ thông tin được trích xuất ở định dạng thích hợp. OutWit Hub cung cấp một giao diện duy nhất để cạo nhỏ hoặc lớn lượng dữ liệu trên mỗi nhu cầu.

Xem thêm: Lịch sử Internet – Wikipedia tiếng Việt

OutWit Hub cho phép bạn cạo bất kỳ trang web nào từ chính trình duyệt và thậm chí tạo các tác nhân tự động để trích xuất dữ liệu và định dạng cho mỗi cài đặt. Nó là một trong những công cụ cạo web đơn giản nhất, miễn phí sử dụng và cung cấp cho bạn sự tiện lợi để trích xuất dữ liệu web mà không cần viết một dòng mã.

Bạn thích công cụ quét web hay add-on nào ? Dữ liệu nào bạn muốn trích xuất từ Internet ? Hãy san sẻ câu truyện của bạn với chúng tôi bằng cách sử dụng phần phản hồi bên dưới .

Source: https://thomaygiat.com

Category : Kỹ Thuật Số

Chuyển vùng quốc tế MobiFone và 4 điều cần biết – MobifoneGo

Muốn chuyển vùng quốc tế đối với thuê bao MobiFone thì có những cách nào? Đừng lo lắng, bài viết này của MobiFoneGo sẽ giúp…

Cách copy dữ liệu từ ổ cứng này sang ổ cứng khác

Bạn đang vướng mắc không biết làm thế nào để hoàn toàn có thể copy dữ liệu từ ổ cứng này sang ổ cứng khác…

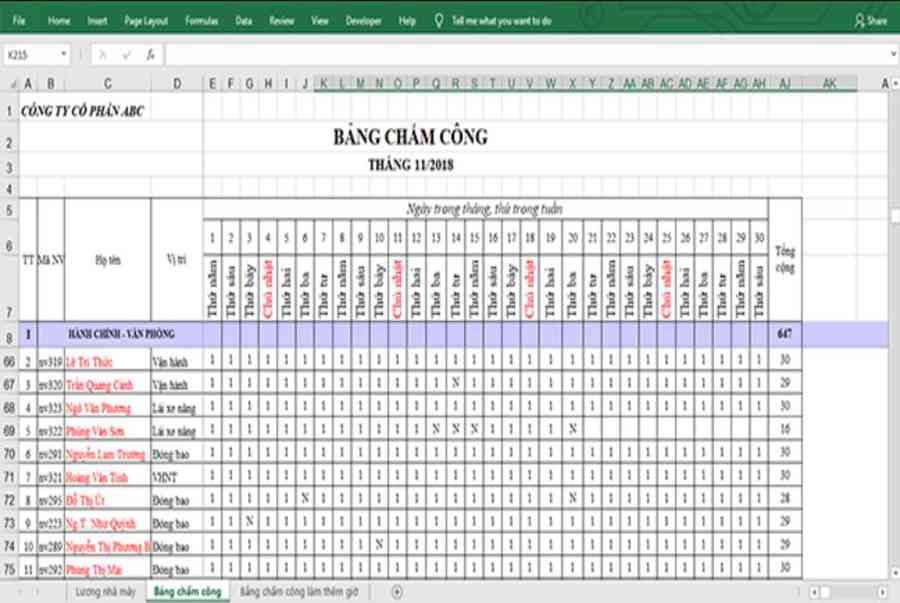

Hướng dẫn xử lý dữ liệu từ máy chấm công bằng Excel

Hướng dẫn xử lý dữ liệu từ máy chấm công bằng Excel Xử lý dữ liệu từ máy chấm công là việc làm vô cùng…

Cách nhanh nhất để chuyển đổi từ Android sang iPhone 11 | https://thomaygiat.com

Bạn đã mua cho mình một chiếc iPhone 11 mới lạ vừa ra mắt, hoặc có thể bạn đã vung tiền và có một chiếc…

Giải pháp bảo mật thông tin trong các hệ cơ sở dữ liệu phổ biến hiện nay

Hiện nay, với sự phát triển mạnh mẽ của công nghệ 4.0 trong đó có internet và các thiết bị công nghệ số. Với các…

4 điều bạn cần lưu ý khi sao lưu dữ liệu trên máy tính

08/10/2020những chú ý khi tiến hành sao lưu dữ liệu trên máy tính trong bài viết dưới đây của máy tính An Phát để bạn…

![Thợ Sửa Máy Giặt [ Tìm Thợ Sửa Máy Giặt Ở Đây ]](https://thomaygiat.com/wp-content/uploads/sua-may-giat-lg-tai-nha-1.jpg)