Cảnh báo đỏ sử dụng Deepfake để lừa đảo – NCS – Công ty Cổ phần Công nghệ An ninh mạng Quốc gia Việt Nam

Báo Đầu tư – Các cá nhân, tổ chức, doanh nghiệp cần cẩn trọng trước thủ đoạn sử dụng công nghệ Deepfake – tạo ra các sản phẩm công nghệ giả dưới dạng âm thanh, hình ảnh hoặc video bằng ứng dụng trí tuệ nhân tạo (AI) – để lừa đảo.

Tạo hình ảnh, giọng nói và video giả mạo để lừa đảo

Mới đây, chị V.T.M. (trú tại quận Long Biên, Hà Nội ) nhận được tin nhắn của một người bạn thân đang sống ở nước ngoài, nhờ chuyển 75 triệu đồng vào tài khoản. Cẩn thận thực hiện cuộc gọi video cho bạn để kiểm tra, thì phía bên kia hiện lên hình ảnh và nói đang cần tiền gấp, nên chị M. không ngần ngại chuyển tiền. Vài tiếng sau, trên Facebook cá nhân của người bạn đó đăng thông báo việc bị kẻ gian đánh cắp tài khoản để hỏi vay tiền bạn bè. Chị M. gọi điện lại, thì người bạn xác nhận đã bị kẻ gian chiếm đoạt tài khoản mạng xã hội.

Bạn đang đọc: Cảnh báo đỏ sử dụng Deepfake để lừa đảo – NCS – Công ty Cổ phần Công nghệ An ninh mạng Quốc gia Việt Nam

Chị M. chỉ là một trong số nhiều nạn nhân được công an TP. TP.HN, TP.Hồ Chí Minh, TP Hà Tĩnh và nhiều tỉnh, thành phố khác … miêu tả, phát đi cảnh báo nhắc nhở về chiêu thức lừa đảo mới với công nghệ tiên tiến Deepfake .

Tại cuộc họp báo thông tin về tình hình, hiệu quả những mặt công tác làm việc quý I / 2023 của Bộ Công an tổ chức triển khai vào ngày 28/3, ông Triệu Mạnh Tùng, Phó cục trưởng Cục An ninh mạng và Phòng chống tội phạm sử dụng công nghệ cao ( Bộ Công an ) cho biết, hiện những đối tượng người tiêu dùng đã sử dụng công nghệ Deepfake ứng dụng AI vào những mục tiêu lừa đảo, chiếm đoạt gia tài. Cụ thể, công nghệ Deepfake được dùng để giả hình ảnh, giọng nói của một người, rồi tương tác với bị hại. Khi chiếm được lòng tin của bị hại, những đối tượng người dùng nhu yếu bị hại thực thi những thanh toán giao dịch kinh tế tài chính để lừa đảo, chiếm đoạt .

Chuyên gia bảo mật thông tin Vũ Ngọc Sơn, Giám đốc Kỹ thuật Công ty NCS cho biết, Deepfake bắt đầu được sử dụng trong những ứng dụng “ hoán đổi khuôn mặt ” giúp người sử dụng thuận tiện thay khuôn mặt, giọng nói của mình vào những nhân vật trong những bộ phim nổi tiếng, rồi đến trào lưu chế ảnh, lồng tiếng vui nhộn cho những clip từng gây sốt thời hạn trước .

“ Gần đây, những kẻ lừa đảo đã tận dụng ứng dụng Deepfake để làm ra những clip có nội dung lừa đảo, mạo danh. Nhiều người đã bị mất tiền do tưởng là người thân trong gia đình, đồng nghiệp, chỉ huy gọi cho mình nhu yếu chuyển một khoản tiền cho họ ”, ông Sơn cho biết .

Theo cơ quan công an, với công nghệ tiên tiến Deepfake, video trá hình có độ đúng chuẩn cao, rất khó phân biệt thật giả. Tuy nhiên, video do đối tượng người dùng tạo sẵn thường có nội dung chung chung, không tương thích trọn vẹn với ngữ cảnh trong thực tiễn tiếp xúc. Để che lấp khuyết điểm này, những đối tượng người dùng thường tạo ra video với âm thanh khó nghe, hình ảnh không rõ nét, giống như cuộc gọi video có tín hiệu chập chờn, được triển khai trong khu vực phủ sóng di động hoặc wifi yếu …Phòng chống lừa đảo như thế nào?

Ông Ngô Minh Hiếu, Nhà sáng lập Dự án Chống lừa đảo nhấn mạnh vấn đề, những cuộc điện thoại thông minh video hiển thị khuôn mặt ít biểu cảm, hướng đầu và khung hình của người trong video không đồng nhất, màu da không bình thường, ánh sáng kỳ lạ, nhiều tiếng ồn, hình ảnh nhòe … là tín hiệu của cuộc gọi Deepfake lừa đảo .

Theo ông Hiếu, khi có một ai đó trên mạng xã hội trong list bè bạn hỏi mượn tiền, hay gửi link lạ, mọi người nên kiểm chứng, xác nhận bằng cách gọi điện thoại cảm ứng trực tiếp hoặc gọi video call tối thiểu trên 1 phút, đặt ra những câu hỏi mà chỉ có bạn và người kia mới biết, vì Deepfake sẽ không hề giả được một cuộc trò chuyện thật sự trong thời gian thực mà có tính chuẩn xác cao .

Chuyên gia Vũ Ngọc Sơn cũng cho biết, do năng lượng đo lường và thống kê của những ứng dụng Deepfake chưa hoàn hảo nhất, nên những clip “ chế ” từ công nghệ tiên tiến này thường có dung tích nhỏ, thời hạn ngắn, chất lượng âm thanh, hình ảnh không cao .

“ Người dùng không nên tin những clip có thời lượng ngắn, chất lượng clip thấp, nhòe, không rõ, khuôn mặt ít biểu cảm, khung hình ít chuyển dời, giọng nói không trơn tru hoặc quá túc tắc, không ngắt nghỉ … ”, chuyên viên Vũ Ngọc Sơn khuyến nghị .Hiện tại, các mạng xã hội phổ biến toàn cầu như Facebook, Twitter, TikTok đều áp dụng công cụ riêng để phát hiện video Deepfake, đồng thời cấm đăng tải nội dung do công nghệ này tạo ra lên nền tảng của họ. Tuy vậy, việc phát hiện chỉ ở mức tương đối và kẻ gian vẫn không ngừng tìm cách để lách qua bộ lọc của mạng xã hội.

Các chuyên viên bảo mật thông tin cảnh báo nhắc nhở, cách tốt nhất để tránh bị làm giả Deepfake là mọi người nên hạn chế san sẻ hình ảnh, video cá thể lên trên mạng ; đồng thời luôn bảo mật thông tin thông tin tài khoản mạng xã hội, email bằng mật khẩu có độ khó cao. Nếu san sẻ video hay clip trên mạng, nên làm méo tiếng của mình, thay bằng tiếng robot hoặc AI voice, để tránh kẻ xấu biết giọng nói thật .

Cơ quan công an cũng khuyến nghị người dùng cá thể, những tổ chức triển khai, doanh nghiệp cần nâng cao cẩn trọng với những cuộc gọi hỏi vay mượn tiền, xác nhận qua video call ; nên xác nhận lại thông tin bằng cách gọi điện thoại cảm ứng hoặc gặp trực tiếp để trao đổi thông tin đúng chuẩn trước khi thanh toán giao dịch. Bên cạnh đó, người dùng nên thận trọng khi san sẻ những thông tin cá thể trên mạng xã hội, không nên để lộ quá nhiều thông tin riêng tư như số nhà, số căn cước công dân …

| Bên cạnh Deepfake, thì lừa đảo bằng công nghệ giả giọng nói (Voice Deepfake) cũng đã được thực hiện. Năm 2019, một công ty năng lượng tại Mỹ bị lừa 243.000 USD khi tội phạm mô phỏng giọng nói của lãnh đạo công ty, yêu cầu nhân viên chuyển tiền cho một nhà cung cấp. Trong năm 2022, tổng số tiền người dùng bị lừa bằng hình thức lừa đảo mô phỏng giọng nói người thân đã lên tới 11 triệu USD. |

Source: https://thomaygiat.com

Category : Nghe Nhìn

Cách SỬA LỖI CAMERA YOOSEE đơn giản NHẤT [2023]

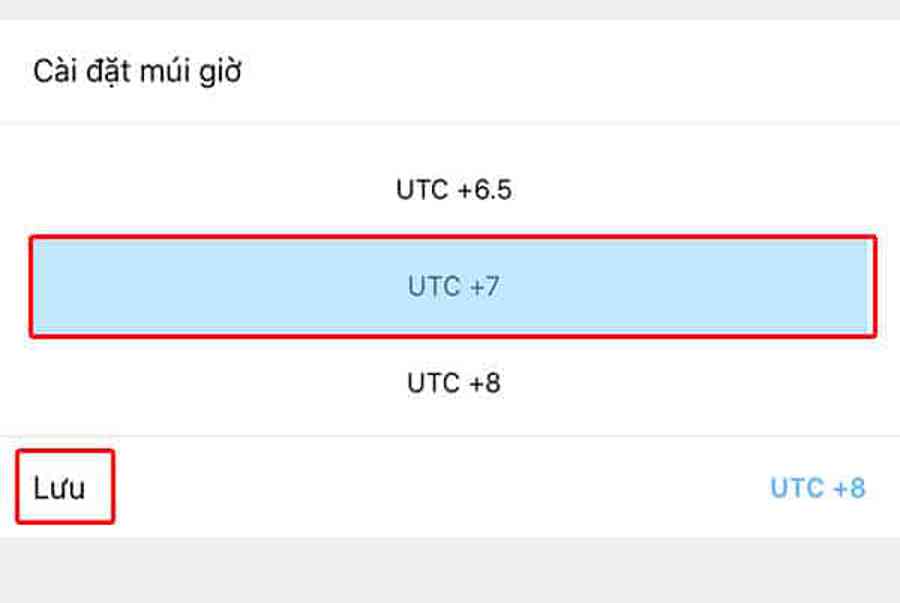

Mục ChínhVideo cách sửa lỗi camera yoosee không liên kết được wifiCamera Yoosee Không Xoay ĐượcCamera Yoosee bị Sai Giờ Lỗi camera Yoosee báo mạng…

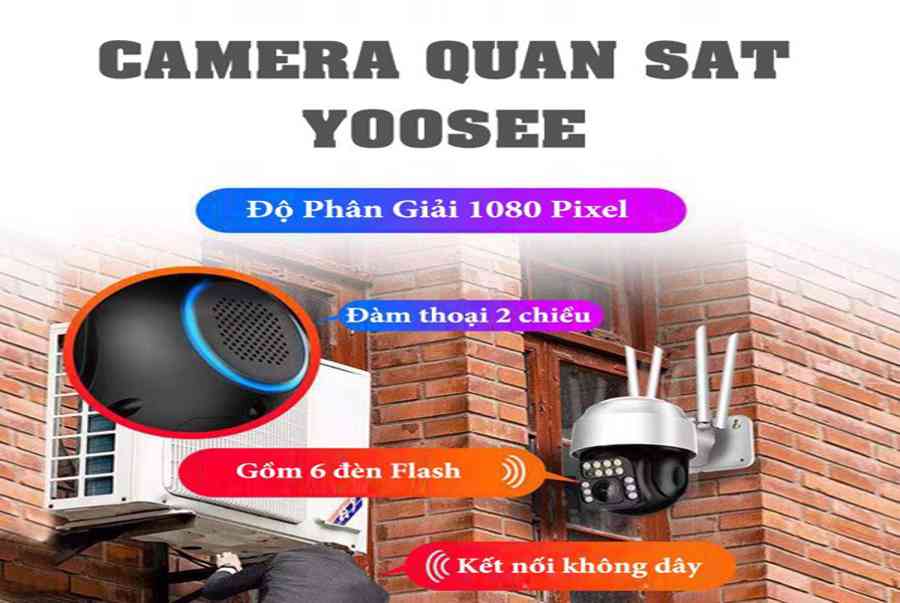

Camera IP Quan Sát Không Dây YooSee 4 Râu C12

Camera IP Quan Sát Không Dây YooSee 4 Râu C12 Camera IP Yosee hạng sang chính hãng model C12 với chất lượng hình ảnh cao…

Camera Wifi Không dây Yoosee HD 3 Râu 1080p – Yoosee Việt Nam

Khả năng xoay linh hoạt dễ dàng quan sát Camera giám sát với khả năng xoay ngang 355°, xoay dọc 120° giúp người dùng dễ dàng…

Cáp Đồng Trục Liền Nguồn Việt Hàn RG59-Cu 1.0 – Chính Hãng

Cáp đồng trục liền nguồn Việt Hàn RG59-Cu 1.0 – cáp lõi đồng nguyên chất, chất lượng cao, giá tốt chính hãng Cáp đồng trục…

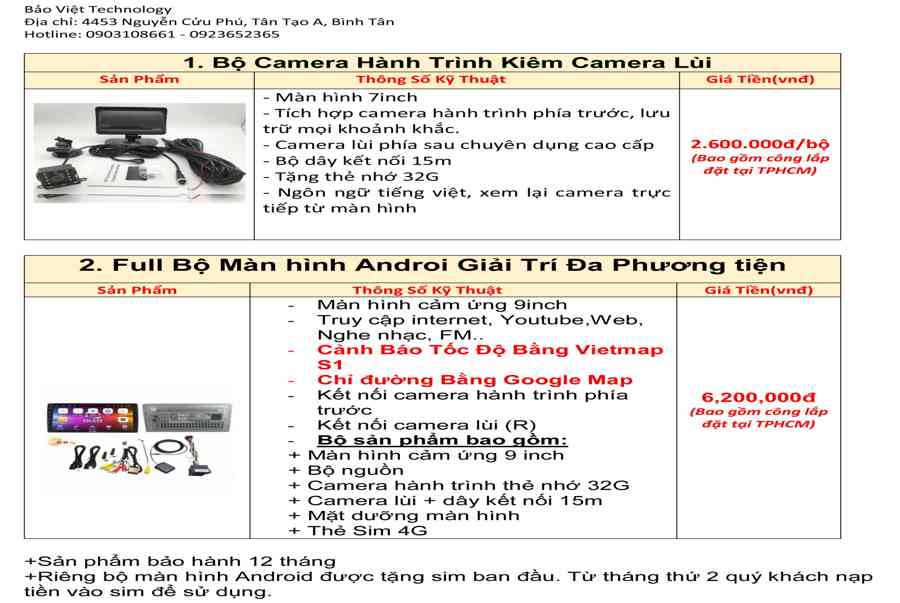

Lắp Đặt Camera Lùi Cho Xe Tải – Bảo Việt Technology

Bạn đang đọc: Lắp Đặt Camera Lùi Cho Xe Tải – Bảo Việt Technology 4.4 / 5 – ( 23 bầu chọn ) Doanh nghiệp…

Camera Logo Design PNG Picture, Camera Logo Design Free Logo Design Template, Logo, Flat, Shot PNG Image For Free Download

Successfully saved Free tải về HD contents without watermark please go to pngtree.com via PCOK Bạn đang đọc: Camera Logo Design PNG Picture, Camera Logo…

![Thợ Sửa Máy Giặt [ Tìm Thợ Sửa Máy Giặt Ở Đây ]](https://thomaygiat.com/wp-content/uploads/sua-may-giat-lg-tai-nha-1.jpg)