Crawl Data là gì? Top 50 phần mềm Crawl dữ liệu | Azgad Agency

Hôm nay, hãy cùng với Azgad Agency tìm hiểu về Crawl Data, cùng đi vào bài viết để biết thêm chi tiết nhé!

Tìm hiểu về Crawl Data

Tìm hiểu về Crawl Data

Crawl Data là gì?

Crawl Data nói một cách thô thiển đó là việc cào dữ liệu, một thuật mới không còn quá xa lạ trong giới Marketing và SEO nữa rồi. Crawl Data là kỹ thuật được sử dụng trong các con robots của các công cụ tìm kiếm như là Google, Bing Yahoo,…

Crawl Data có việc làm chính là thu thập dữ liệu từ một trang web bất kể nào đó và thực thi việc nghiên cứu và phân tích mã nguồn HTML của nó, sau đó đọc dữ liệu và lọc ra theo đúng như nhu yếu của người dùng hay người sử dụng dữ liệu nhu yếu .

Web Crawler là gì?

Đây là một quy trình kỹ thuật tự động hóa truy vấn vào website và tích lũy thông tin trải qua một chương trình ứng dụng đơn cử .

Mục tiêu của những con bot chương trình này đó là tìm hiểu và khám phá về hầu hết các website có trên trang nào đó. Để xem xem là chúng đang nói về những gì, đề tài gì được nói tới, từ đó mà xem xét và truy xuất các thông tin khi thiết yếu. Các con bot này luôn luôn được quản lý và vận hành bởi những công cụ tìm kiếm .

Áp dụng những thuật toán cào dữ liệu như vậy thì khi mà có người dùng nào đó tìm kiếm bằng một từ khóa trên công cụ tìm kiếm, thì ngay lập tức các công cụ tìm kiếm hoàn toàn có thể hiển thị ngay cho người dùng các tác dụng tương quan .

Nó sẽ tạo ra một list đơn cử các trang có chứa nội dung tương quan đến từ khóa mà người dùng tìm kiếm và hiển thị nó ra ở phần hiệu quả kiếm cho bạn .

Tuy nhiên thì lúc bấy giờ lượng thông tin hiện ra tác dụng tìm kiếm ngày càng lớn, hoàn toàn có thể nói là lớn vô cùng, không hề đếm được, cho nên vì thế cho nên người dùng sẽ không thể nào biết được các thông tin này đã được index đúng cách hay chưa ?

Và vì như vậy do đó các con bot tích lũy thông tin từ web sẽ khởi đầu tích lũy từ những website phổ cập trước, lần lượt sau đó sẽ là các siêu link, link từ trang này đến trang khác, đến tận các trang bổ trợ, …

Cách Crawl dữ liệu trang web

Công nghệ về internet ngày càng được lan rộng ra và không ngừng đổi khác tân tiến hơn. Vì thế cho đến lúc bấy giờ không ai hoàn toàn có thể đo lường và thống kê và đoán đúng mực được số lượng website đang có trên internet, Crawl Data sẽ mở màn việc làm của mình bằng list các đường link đã biết từ trước .

Đầu tiên thì chúng sẽ Crawl Data từ những các webpage tại các URL biết trước đó. Sau đó thì khởi đầu từ các webpage này mà các con bot Crawl Data sẽ biết được và tìm thấy được các siêu link đến từ nhiều URL khác, nó sẽ thêm các URL mới này vào list của mình để liên tục việc Crawl Data .

Với việc mà mỗi ngày có thêm rất nhiều website được tạo, và số lượng website đang rất lớn như vậy thì những website như vậy phải được lập chỉ mục để tìm kiếm .

Quá trình này sẽ hoàn toàn có thể được diễn ra vô thời hạn, không dừng lại được. Tuy nhiên với việc Crawl Data, Crawler sẽ tuân theo các chủ trương nhất định giúp cho quy trình Crawl Data có nhiều sự lựa chọn hơn trước .

Hầu hết các con bot Crawl Data sẽ không khi nào thu thập toàn bộ thông tin có sẵn trên internet, thay vào đó các con bot Crawl Data này sẽ quyết định hành động các website sẽ thu thập dữ liệu tiên phong dựa vào các yếu tố như số lượng các website khác link với trang đó, lượng khách truy vấn nhận được, và một số ít yếu tố khác, …

Lý do rất đơn thuần đó là vì những website mà được nhiều website khác link, và được nhiều người dùng truy vấn vào thì chắc như đinh trang đó sẽ là trang có năng lực chứa thông tin tương quan tới người dùng đang chăm sóc nhất. Cho nên các con bot Crawl Data sẽ ưu tiên hơn trong việc cào dữ liệu ở những website như vậy .

Dựa vào giao thức robots.txt mà các con bot Crawl Data cũng sẽ quyết định hành động những trang nào sẽ tích lũy thông tin trước, những trang nào chúng sẽ tích lũy thông tin sau. Trước khi việc cào dữ liệu được thực thi thì những con bot sẽ kiểm tra tệp tin robots.txt trước đó .

Tệp robots.txt này là một dạng tệp văn bản chỉ định các quy tắc cho bất kỳ một con bot nào có thể hay không truy cập và trang web đó.

Xem thêm: 7 phương pháp dạy học tiếng việt theo hướng phát triển năng lực hiệu quả – https://thomaygiat.com

Những yếu tố này có trọng số khác nhau và còn tùy thuộc nhiều vào thuật toán của mỗi công cụ tìm kiếm vận dụng nữa. Các con bot Crawl Data từ các công cụ tìm kiếm khác nhau sẽ hoạt động giải trí với chính sách khác nhau, nhưng dù vậy thì tiềm năng sau cuối của chúng là giống nhau trọn vẹn. Cùng tải xuống các nội dung và index chúng .

Tạo ra tool Crawl Data Python cần những gì?

Đôi khi tất cả chúng ta sẽ muốn tự mình hoàn toàn có thể tạo ra một cái tool gì đấy để ship hàng cho quy trình cào dữ liệu, ship hàng cho tiềm năng cá thể của mình. Tuy nhiên thì không phải cứ muốn tạo ra tool là tạo được liền đâu, bạn cần phải có kiến thức và kỹ năng cũng như kinh nghiệm tay nghề trong việc tạo tool với Python thì mới làm được việc này. Một số kỹ năng và kiến thức / kinh nghiệm tay nghề cần có như :

- Nắm được cơ bản cho đến nâng cao cấu trúc của 1 trang web.

- Nắm vững kiến thức về HTML, CSS Selector, XPath.

- Có kiến thức vững về ngôn ngữ Python.

- Có kiến thức cũng như am hiểu rõ về Dev Tools của trình duyệt.

Nếu không có những thứ như ở trên thì bạn rất khó hoàn toàn có thể tạo được cho mình một cái tool hoàn toàn có thể Crawl Data được .

Top 50 phần mềm Crawl dữ liệu trang web

| Tên phần mềm | Ngôn ngữ lập trình | Nền tảng |

| Heritrix | Java | Linux |

| Nutch | Java | Cross-platform |

| Scrapy | Python | Cross-platform |

| DataparkSearch | C++ | Cross-platform |

| GNU Wget | C | Linux |

| GRUB | C#, C, Python, Perl | Cross-platform |

| ht://Dig | C++ | Unix |

| HTTrack | C/C++ | Cross-platform |

| ICDL Crawler | C++ | Cross-platform |

| mnoGoSearch | C | Windows |

| Norconex HTTP Collector | Java | Cross-platform |

| Open Source Server | C/C++, Java PHP | Cross-platform |

| PHP-Crawler | PHP | Cross-platform |

| YaCy | Java | Cross-platform |

| WebSPHINX | Java | Cross-platform |

| WebLech | Java | Cross-platform |

| Arale | Java | Cross-platform |

| JSpider | Java | Cross-platform |

| HyperSpider | Java | Cross-platform |

| Arachnid | Java | Cross-platform |

| Spindle | Java | Cross-platform |

| Spider | Java | Cross-platform |

| LARM | Java | Cross-platform |

| Metis | Java | Cross-platform |

| SimpleSpider | Java | Cross-platform |

| Grunk | Java | Cross-platform |

| CAPEK | Java | Cross-platform |

| Aperture | Java | Cross-platform |

| Smart and Simple Web Crawler | Java | Cross-platform |

| Web Harvest | Java | Cross-platform |

| Aspseek | C++ | Linux |

| Bixo | Java | Cross-platform |

| crawler4j | Java | Cross-platform |

| Ebot | Erland | Linux |

| Hounder | Java | Cross-platform |

| Hyper Estraier | C/C++ | Cross-platform |

| OpenWebSpider | C#, PHP | Cross-platform |

| Pavuk | C | Linux |

| Sphider | PHP | Cross-platform |

| Xapian | C++ | Cross-platform |

| Arachnode.net | C# | Windows |

| Crawler | C++ | Java |

| Distributed Web Crawler | C, Java, Python | Cross-platform |

| iCrawler | Java | Cross-platform |

| pycreep | Java | Cross-platform |

| Opese | C++ | Linux |

| Andjing | Java | |

| Ccrawler | C# | Windows |

| WebEater | Java | Cross-platform |

| JoBo | Java | Cross-platform |

Những câu hỏi xoay quanh vấn đề Crawl Data

Revisiting webpages là gì?

Đây là một quy trình mà các con bot Crawl Data sẽ truy vấn các trang web định kỳ để index nội dung mới nhất trên này .

Tại sao con bot Crawl Data được gọi là spiders?

Việc mà gọi các con bot thu thập dữ liệu là spiders là trọn vẹn tự nhiên, tại vì các con bot này tích lũy các dữ liệu trên khắp các website, chúng tích lũy giống như là những con nhện đang bò vậy .

Các con bot thu thập dữ liệu có được phép truy cập vào các thuộc tính trên website không?

Trên trong thực tiễn vì việc mà các con bo thu thập dữ liệu website có được truy vấn vào các thuộc tính trên website hay không thì còn phụ thuộc vào rất nhiều vào 1 số ít yếu tố đi kèm khác .

Sở dĩ các con bot tích lũy thông tin website nhu yếu nguồn từ sever là để lấy cơ sở index dữ liệu, nội dung. Chúng thường sẽ đưa ra các nhu yếu mà sever cần phản hồi, ví dụ điển hình như thông tin về việc có người dùng truy vấn vào website, hoặc là thông tin về việc có các con bot khác đang truy vấn vào website .

Tùy vào việc có bao nhiêu nội dung trên website hay có bao nhiêu trang con trên website mà các nhà điều hành quản lý website sẽ xem xét là có nên hay không nên index nội dung tiếp tục. Vì index quá nhiều sẽ hoàn toàn có thể dẫn đến thực trạng hỏng máy chủ và tốn thêm ngân sách về bằng thông .

Cũng có thêm một số ít trường hợp đó là người quản trị web không muốn hiển thị lên 1 số ít website nào đó. Trừ khi người dùng được nhà quản trị web phân phối link để đến trang đấy thì mới hoàn toàn có thể thấy được .

Các con bot thu thập dữ liệu trang web ảnh hưởng như thế nào đến SEO?

SEO được cho là một quy trình tối ưu các nội dung cho website, và góp thêm phần để trang được index, hiển thị trong tác dụng của công cụ tìm kiếm .

Và đương nhiên nếu như các con bot không tích lũy được dữ liệu từ website của bạn thì hiển nhiên rằng nội dung của bạn sẽ không được index và hiển thị trong hiệu quả tìm kiếm của công cụ tìm kiếm được rồi .

Chính vì nguyên do này vì vậy các SEOer khi thực thi quy trình làm SEO thì không nên chặn hoạt động giải trí của các con bot Crawl Data. Nếu chặn thì việc bỏ thời hạn và công sức của con người làm SEO của bạn coi như là công cốc hết .

Quản lý bot Crawl Data tại sao lại là quan trọng nên làm?

Thường thì các con bot sẽ được chia thành 2 loại: bot an toàn và bot độc hại. Với những con bot độc hại thì nó sẽ khiến cho trang web của bạn chịu rất nhiều thiệt hại từ việc trải nghiệm của người dùng bị kém đi, cho đến nặng hơn là những máy chủ bị sự cố xảy ra tình trạng đánh cắp dữ liệu.

Vẫn có giải pháp để bạn hoàn toàn có thể ngăn ngừa được thực trạng diễn ra này đó là hãy được cho phép những con bot bảo đảm an toàn truy vấn vào website của bạn, ví dụ điển hình như con bot Crawl Data .

Vừa rồi là những chia sẻ của Azgad Agency về những thông tin liên quan tới Crawl Data. Nếu như bạn cảm thấy bài viết này hay và bổ ích thì đừng ngại và chia sẻ nó cho những người khác với nhé. Hẹn gặp lại các bạn ở những bài viết tiếp theo!

Tác giả: Trần Hoài Nam

Source: https://thomaygiat.com

Category : Kỹ Thuật Số

Chuyển vùng quốc tế MobiFone và 4 điều cần biết – MobifoneGo

Muốn chuyển vùng quốc tế đối với thuê bao MobiFone thì có những cách nào? Đừng lo lắng, bài viết này của MobiFoneGo sẽ giúp…

Cách copy dữ liệu từ ổ cứng này sang ổ cứng khác

Bạn đang vướng mắc không biết làm thế nào để hoàn toàn có thể copy dữ liệu từ ổ cứng này sang ổ cứng khác…

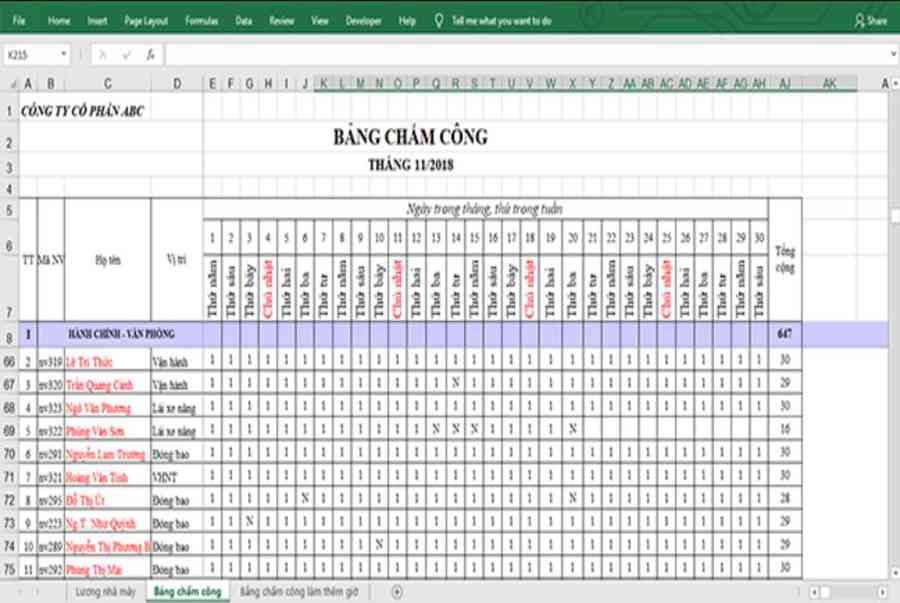

Hướng dẫn xử lý dữ liệu từ máy chấm công bằng Excel

Hướng dẫn xử lý dữ liệu từ máy chấm công bằng Excel Xử lý dữ liệu từ máy chấm công là việc làm vô cùng…

Cách nhanh nhất để chuyển đổi từ Android sang iPhone 11 | https://thomaygiat.com

Bạn đã mua cho mình một chiếc iPhone 11 mới lạ vừa ra mắt, hoặc có thể bạn đã vung tiền và có một chiếc…

Giải pháp bảo mật thông tin trong các hệ cơ sở dữ liệu phổ biến hiện nay

Hiện nay, với sự phát triển mạnh mẽ của công nghệ 4.0 trong đó có internet và các thiết bị công nghệ số. Với các…

4 điều bạn cần lưu ý khi sao lưu dữ liệu trên máy tính

08/10/2020những chú ý khi tiến hành sao lưu dữ liệu trên máy tính trong bài viết dưới đây của máy tính An Phát để bạn…

![Thợ Sửa Máy Giặt [ Tìm Thợ Sửa Máy Giặt Ở Đây ]](https://thomaygiat.com/wp-content/uploads/sua-may-giat-lg-tai-nha-1.jpg)